Ethik und AI

April 30, 2020

Im Rahmen des CAS Digital Ethics der HWZ hatten wir das Vergnügen, uns im Rahmen einer sehr intensiven Zoom-Session mit Ethik und AI, mit Ethik im Kontext künstlicher Intelligenz zu beschäftigen und von dem geballten Knowhow der Dozentin zu profitieren.

Um das doch sehr weitläufige und abstrakte Thema auch nur ansatzmässig in den Griff zu bekommen, unternehmen wir zu Beginn einen kurzen Abstecher in die allgemeine Ethik.

Die zentralen Punkte der Ethik sind Fragen die sich um Werte, Normen und Pflichten der Menschen drehen. Wie sollen wir leben? An welchen Zielvorstellungen orientieren wir uns? Welche Normen braucht es für ein Zusammenleben, welche Pflichten ergeben sich daraus?

Diese Grundfragen können wir auf alles anwenden, das wir gestalten und durch unser Handeln beeinflussen. Was hingegen nicht beeinflussbar ist, ist nicht Teil der Ethik, wie beispielsweise Naturphänomene. Die Frage stellt sich nun, wie sich das mit künstlicher Intelligenz (KI) verhält. In wieweit können wir als Menschen die künstliche Intelligenz überhaupt beeinflussen? Ist das notwendig und falls ja, wie könnte ein Lösungsansatz aussehen?

Es stellt sich nun die Frage, an welchen ethischen Werten wir uns bei der Entwicklung und Verwendung von künstlicher Intelligenz orientieren, wenn die Interaktion nicht mehr von Mensch zu Mensch sondern von Mensch zu künstlicher Intelligenz zu Mensch funktioniert.

Welche Rechte und Pflichten haben wir bei der Nutzung der künstlichen Intelligenz? Wie gehen wir mit einer Technologie um, die dazwischen liegt und die sich oft als Blackbox präsentiert. Das Blackbox Problem wird von Marcel Blattner vom CAS AI Management der HWZ in diesem Video anschaulich erklärt. https://www.youtube.com/watch?v=JgXbm6MtN38&t=620s. Die Frage stellt sich dabei, wo die Verantwortung der Menschen endet. Endet sie überhaupt?

Wenn wir nicht verstehen, was innerhalb der Blackbox der künstlichen Intelligenz passiert, entmündigen wir uns als Mensch und entziehen uns der ethischen Verantwortung, da wir das Verständnis für die Welt und die Dinge nicht mehr suchen.

Es ist dabei zu beachten, dass der Begriff künstliche Intelligenz in verschiedenen Ausprägungen benutzt wird. Die Varianz des Begriffs reicht von programmierten regelbasierten Systemen über manuell trainierte Systeme bis hin zu Deep Learning, der Ausprägung von Machine Learning bei der die Komplexität im Detail die Grenze der Erklärbarkeit erreicht.

Um die ethische Verankerung im Umfeld von KI sicherstellen zu können, bieten sich vier Ebenen mit entsprechenden Massnahmen und Instrumenten an.

Es sind dies die Ebenen Staat / Gesellschaft mit Regulierungen zum Datenschutz und Vorschriften zur Transparenz wie beispielsweise die Datenschutz-Grundverordnung (DSGVO) und das California Bot Law.

Instrumente auf der Ebene Unternehmung zur good Corporate Digital Responsibility können beispielsweise ein Code of Conduct, ein Ethik Board sowie Trainings und Education Massnahmen sein.

Auf der Ebene der Menschen greifen vor allem Massnahmen zur Sicherstellung der Diversity wie gemischte Teams, die Faktoren wie Alter, Gender, kultureller und disziplinärer Hintergrund angemessen berücksichtigen.

Schliesslich gibt es auf technischer Ebene Möglichkeiten, Ethik zu «kodifizieren». In diesem Zusammenhang ist der Ansatz der von Differential Privacy interessant. Dabei werden durch künstliches Beimischen von «Datanoise» einzelne Datensätze verändert. Dies verhindert eine Deanonymisierung einzelner Datensätze durch das Kombinieren mit anderen Daten soll so verunmöglicht werden. Um die Auswertungen nicht zu kompromittieren, wird der bekannte Effekt des «Datanoise» in der statistischen Auswertungen wieder herausgerechnet . Dieses Video veranschaulicht das Konzept. https://www.youtube.com/watch?v=gI0wk1CXlsQ

Für mich speziell von Interesse ist der inhärente Konflikt zwischen der DSGVO und dem Machine Learning.

Die DSGVO schreibt vor, dass ein Mensch jederzeit Auskunft erhalten kann über die ihn betreffenden Daten. Zudem dürfen Algorithmen keine Entscheide rein ohne menschliches Zutun treffen. (Human in the loop). Egal was kodifiziert wurde, es braucht immer noch menschliches Urteilsvermögen.

Die technische Funktionsweise von Machine Learning beruht aber darauf, möglichst viele Daten zu nutzen. Ausserdem erreicht die Funktionsweise als Blackbox die Grenze des Erklärbaren vor allem bei echtem Machine Learning. Dies widerspricht grundsätzliche der DSGVO und dem ethischen Grundansprüchen wie Transparenz, Rechenschaft, Nachvollziehbarkeit nicht. Machine Learning in der Ausprägung von Deep Learning, genügt den ethischen Ansprüchen von Menschen nicht und ist daher wohl generell als unethisch einzustufen.

Bei älteren KI-Systemen ist diese Aussage in dieser absoluten Ausprägung nicht korrekt, da die älteren Generationen von KI durch Menschen programmiert und/oder trainiert werden. Die Algorithmen können durch menschliche Experten noch nachvollzogen werden.

Es ist für mich als vernunftbegabten Menschen generell nicht nachvollziehbar, weshalb wir Homo Sapiens als die nach aktuellem Wissensstand höchstentwickelte Gattung Lebewesen auf dem Planet Erde darauf hinarbeiten, mit Machine Learning eine andere Art von selbstlernender Intelligenz zu erschaffen, deren genaue Wirkungsweise uns nicht mehr bekannt oder gar von uns beeinflussbar ist. Es ist wohl das erste Mal überhaupt, dass eine Gattung ihre Vormachtstellung in ihrem Habitat freiwillig preisgeben will, ja, diese Entwicklung sogar aktiv initiiert.

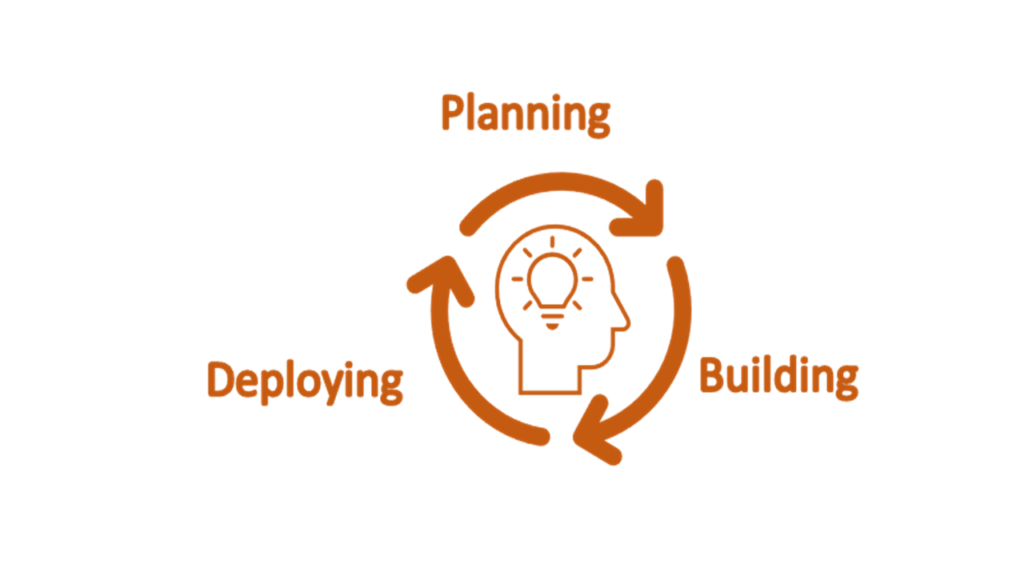

Wie können die Beteiligten also sicherstellen, dass sie künstliche Intelligenz nach ethischen Grundsätzen beurteilten resp. unter Einhaltung ethischer Grundsätze nutzen? Dafür ist es wichtig, dass sie den gesamte Prozess unter ethischen Kriterien betrachten. Es reicht nicht, ethische Grundsätze allein auf die Programmierung zu fokussieren. Die Komplexität der Anforderungen verlangt mehr. Aber es ist sehr wichtig, dass Diejenigen, die den technologischen Fortschritt vorwärtstreiben, sich mit ethischen Fragen auseinandersetzen.

Wichtig ist die Betrachtung des gesamten Entwicklungszyklus, sowohl Planning, Building und Deploying.

Das Projektteam respektive die Auftraggeber sollen bereits in der Phase Planung die Ziele der Algorithmen von Beginn weg definieren und die einzuhaltenden Werte priorisieren. Worum geht es beim Einsatz von KI? Welchen Nutzen und Effekt möchte das Projekt erreichen? Wie werden Ziele und Werte priorisiert? Dies können Werte wie Geschwindigkeit, Qualität oder auch andere Ziele sein. Das Projektteam soll bereits in der Planung klären, ob die zu erreichende Zielfunktion per se ethisch ist. Als generalisierte Maxime könnte die Aussage stehen: «AI systems should make the world a better place».

Wenn beispielsweise die Programmierung eines automatisierten Fahrzeugs im Falle von drohenden Kollisionen nur den optimalen Schutz der Fahrgäste als Ziel hat und die Kollateralschäden der anderen Kollisionsteilnehmern ausser Acht lässt, wird auch die ausgefeilteste Programmierung diesen Algorithmus nicht in die ethisches Konformität retten.

Spezielle Aufmerksamkeit benötigen in allen Phasen die unterliegenden Daten. Weisen diese Daten, vor allem jene die zum Trainieren eines KI Systems herangezogen werden, einen Bias auf, wird das KI System mit diesem Bias trainiert. Die Wahrscheinlichkeit ist hoch, dass die Resultate der KI diesen Bias noch verstärken. Dabei ist zu unterscheiden, dass ein Bias eine technische Ausprägung der Daten beschreibt und nicht gleichzusetzen ist mit einer Diskriminierung. Ein Bias ist nicht wertend, also nicht «gut» oder «schlecht», sondern beschreibt eine statistisch relevante systematische Verzerrung in den Daten. Diskriminierung kann aus einem Bias entstehen oder aber kann die Ursache für einen Bias sein. Diskriminierung betrifft Eigenschaften, die als Basis für ungerechtfertigte und systematische Ungleichbehandlung in der Vergangenheit dienten.

Um ein Bias zu vermeiden, ist im Umgang mit den Ausgangsdaten viel Sorgfalt und eine kritische Betrachtung notwendig. Sind die Datensample für den zu trainierenden Zweck wirklich repräsentativ und neutral, besteht keine Verzerrung in diesen Daten? Es ist deshalb wichtig, die Modelle zu überprüfen und die Resultate zu validieren, zu monitoren und allenfalls zu optimieren. Denn nach wie vor, kann KI auf Basis statistischer Verfahren hervorragend Korrelationen ausrechnen und aufzeigen, Kausalität herstellen kann sie aber nicht.

Dieser Blogbeitrag wurde von einem Studierenden verfasst und beinhaltet subjektive Eindrücke, eigene Darstellungen und Ergänzungen.

Bleibe auf dem Laufenden über die neuesten Entwicklungen der digitalen Welt und informiere dich über aktuelle Neuigkeiten zu Studiengängen und Projekten.